增加異常捕獲,更容易現(xiàn)問題的解決方向

import ssl

import urllib.request

from bs4 import BeautifulSoup

from urllib.error import HTTPError, URLError

def get_data(url):

headers = {"user-agent":

"Mozilla/5.0 (Macintosh; Intel Mac OS X 10_15_7) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/90.0.4430.93 Safari/537.36"

}

ssl._create_default_https_context = ssl._create_unverified_context

"""

urlopen處增加兩個異常捕獲:

1���、如果頁面出現(xiàn)錯誤或者服務器不存在時,會拋HTTP錯誤代碼

2����、如果url寫錯了或者是鏈接打不開時���,會拋URLError錯誤

"""

try:

url_obj = urllib.request.Request(url, headers=headers)

response = urllib.request.urlopen(url_obj)

html = response.read().decode('utf8')

except (HTTPError, URLError)as e:

raise e

"""

BeautifulSoup處增加異常捕獲是因為BeautifulSoup對象中有時候標簽實際不存在時�����,會返回None值�����;

因為不知道��,所以調用了就會導致拋出AttributeError: 'NoneType' object has no xxxxxxx�。

"""

try:

bs = BeautifulSoup(html, "html.parser")

results = bs.body

except AttributeError as e:

return None

return results

if __name__ == '__main__':

print(get_data("https://movie.douban.com/chart"))

解析html�,更好的實現(xiàn)數(shù)據展示效果

# 此處代碼同上面打開url代碼一致,故此處省略......

html = response.read().decode('utf8')

bs = BeautifulSoup(html, "html.parser")

data = bs.find('span', {'class': 'pl'})

print(f'電影評價數(shù):{data}')

print(f'電影評價數(shù):{data.get_text()}')

運行后的結果顯示如下:

電影評價數(shù):span class="pl">(38054人評價)/span>

電影評價數(shù):(38054人評價)

- find() 方法是過濾HTML標簽�,查找需要的單個標簽

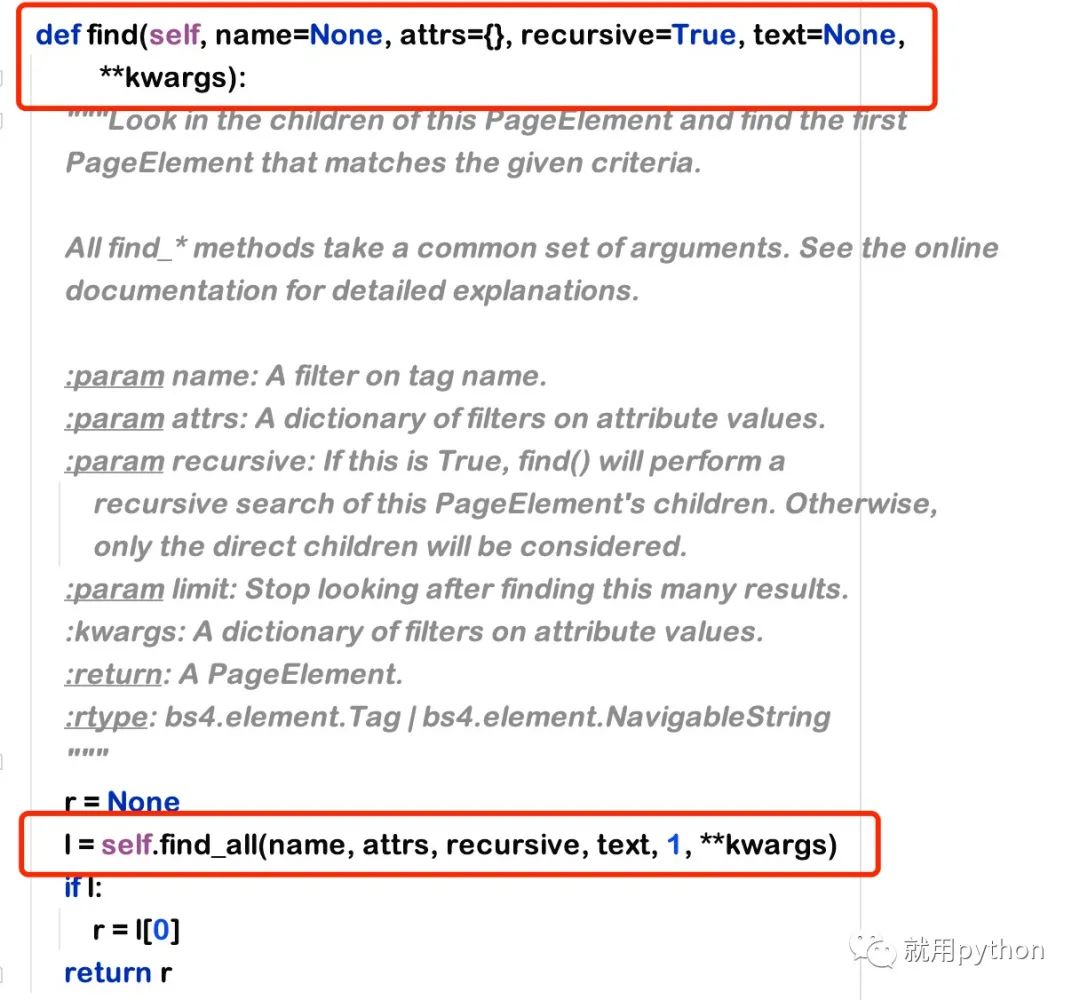

實際find方法封裝是調用了正則find_all方法,把find_all中的limt參數(shù)傳1�����,獲取單個標簽

1.name:可直接理解為標簽元素

2.attrs:字典格式,放屬性和屬性值 {"class": "indent"}

3.recursive:遞歸參數(shù)��,布爾值�����,為真時遞歸查詢子標簽

4.text:標簽的文本內容匹配 , 是標簽的文本��,標簽的文本

- find_all() 方法是過濾HTML標簽�����,查找需要的標簽組

使用方法適合find一樣的�,無非就是多了個limit參數(shù)(篩選數(shù)據)

必須注意的小知識點:

# 下面兩種寫法,實際是一樣的功能�,都是查詢id為text的屬性值

bs.find_all(id="text")

bs.find_all(' ', {"id": "text"})

# 如果是class的就不能class="x x x"了,因為class是python中類的關鍵字

bs.find_all(class_="text")

bs.find_all(' ', {"class": "text"})

到此這篇關于python爬蟲之異常捕獲及標簽過濾詳解的文章就介紹到這了,更多相關python異常捕獲及標簽過濾內容請搜索腳本之家以前的文章或繼續(xù)瀏覽下面的相關文章希望大家以后多多支持腳本之家��!

您可能感興趣的文章:- python爬蟲之selenium庫的安裝及使用教程

- Python中selenium庫的用法詳解

- Python Selenium庫的基本使用教程

- Python爬蟲之Selenium庫的使用方法

- python中selenium庫的基本使用詳解

- Python中Selenium庫使用教程詳解

- Requests什么的通通爬不了的Python超強反爬蟲方案�����!

- Python爬蟲之獲取心知天氣API實時天氣數(shù)據并彈窗提醒

- 快速搭建python爬蟲管理平臺

- Python爬蟲基礎之selenium庫的用法總結